Regresyon analizi

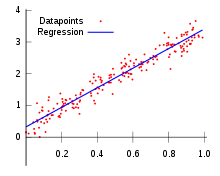

Regresyon analizi, iki ya da daha çok değişken arasındaki ilişkiyi ölçmek için kullanılan analiz metodudur. Eğer tek bir değişken kullanılarak analiz yapılıyorsa buna tek değişkenli regresyon, birden çok değişken kullanılıyorsa çok değişkenli regresyon analizi olarak isimlendirilir. Regresyon analizi ile değişkenler arasındaki ilişkinin varlığı, eğer ilişki var ise bunun gücü hakkında bilgi edilinebilinir. Regresyon terimi için öz Türkçe olarak bağlanım sözcüğü kullanılması teklif edilmiş ise de [1] Türk ekonometriciler arasında bu kullanım yaygın değildir.

Örneğin, bir ziraatçı buğday verimi ve gübre miktarı arasındaki ilişkiyi, bir mühendis, basınç ve sıcaklık, bir ekonomist gelir düzeyi ve tüketim harcamaları, bir eğitimci öğrencilerin devamsızlık gösterdiği gün sayıları ve başarı dereceleri arasındaki ilişkiyi bilmek isteyebilir. Regresyon, iki (ya da daha çok) değişken arasındaki doğrusal ilişkinin fonksiyonel şeklini, biri bağımlı diğeri bağımsız değişken olarak bir doğru denklemi olarak , göstermekle kalmaz, değişkenlerden birinin değeri bilindiğinde diğeri hakkında kestirim yapılmasını sağlar. Genellikle bu iki (veya çok) değişkenlerin hepsinin niceliksel ölçekli olması zorunluluğu vardır.

Regresyonda, değişkenlerden biri bağımlı diğerleri bağımsız değişken olmalıdır. Buradaki mantık eşitliğin solunda yer alan değişkenin sağında yer alan değişkenlerden etkilenmesidir. Sağda yer alan değişkenlerse diğer değişkenlerden etkilenmemektedir. Burada etkilenmemek matematiksel anlamda bu değişkenleri bir doğrusal denkleme koyduğumuzda etki yapması anlamındadır. Çoklu doğrusallık, ardışık bağımlılık sorunları kastedilmemektedir.

Regresyon analizinin tarihi

Regresyon yönteminin ilk şekli en küçük kareler prensibidir ve ilk olarak Adrien Marie Legendre tarafından 1805de ortaya atılmıştır [2]. Hemen takiben 1809da C.F. Gauss [3] aynı yöntemi açıklamıştır. En küçük kareler terimi Legendre tarafından moindres carrés olarak kullanılmış, ancak Gauss aynı yöntemi 1795den beri kullandığını iddia etmiştir. Legendre ve Gauss bu yöntemi astronomik gözlemlerden uydularının güneş etrafındaki yörüngelerini tespit etmek için kullanırken ortaya çıkartmışlardır. 1748de Eüler'in aynı problem üzerinde uğraştığı, fakat başarı sağlayamadığı bilinmektedir. En küçük kareler kuramında sonraki gelişme Gauss'in 1821de yayınladığı bir makalede ortaya çıkartılmış[4] ve bu yayında Gauss sonradan kendi adı verilen Gauss-Markov teoreminin bir şeklini açıklamıştır.

Regresyon terimi 19. yüzyılda İngiliz istatistikçisi Francis Galton tarafından bir biyolojik inceleme için ortaya atılmıştır. Bu incelemenin ana konusu kalıtım olup, aile içinde baba ve annenin boyu ile çocukların boyu arasındaki bağlantıyı araştırmakta ve çocukların boylarının bir nesil içinde eski ata nesillerinin ortalamasına geri döndüklerini yani bir nesil içinde ortalamaya geri dönüş olduğu inceleme konusudur. Galton geri dönüş terimi için ilk yazısında İngilizce olarak reversion terimi kullanmışsa da sonradan aynı anlamda olan regression sözcüğü kullanmıştır.[5];[6] Bu çalışmalarında Galton istatistiksel 'regresyon' kavramını ve yöntemini de geliştirmiştir. Udny Yüle ve Karl Pearson bu yöntemi daha geniş genel istatistiksel alanlara uygulayıp geliştirmişlerdir..[7][8]. Bu yazılarda bağımlı ve bağımsız değişkenlerin normal dağılım gösterdiği varsayılmaktadır. Bu kısıtlayıcı varsayım R.A. Fisher 1922 ve 1925de yayınlar ile sadece bağımlı değişkenin koşullu dağılımının normal olduğu hallere uygulanmak üzere daha genişletilmiştir.[9][10]).

Bu kavramları ve yöntemleri genel olarak, kalıtım konusu dışında "ortalamaya geri dönüş" ile hiçbir ilgisi olmayan konularda, kullanan istatistikçiler regresyon terimini kullanmakta devam etmişlerdir. Zamanımızda, bu terim, kavram ve yöntemin Galton'un konusu ile bütün ilişkisi yok olmuştur ve artık regresyon terimi doğrusal bağlantı bulunması ve eğri uydurma ile eş anlamlar vermektedir.

Temeldeki varsayımlar

Doğrusal regresyon yöntemini kullanmak için temelde şu varsayımların bulunduğu kabul edilmektedir:[1]

- Çıkarımsal yöntem olduğu için kullanılan iki değişkenli örneklemin ya istatistiksel rastgele örneklem olduğu ya da anakütleyi çok iyi temsil ettiği bilinmektedir.

- Bağımlı değişken içinde hata bulunmaktadır. Bu hatanın bir rassal değişken olduğu ve ortalama hatanın sıfır olduğudur. Sistematik hata da bulunması mümkündür ama bu hatanın incelemeye alınması regresyon analizi kapsamı dışındadır.

- Bağımsız değişken hatasızdır. Eğer bağımsız değişkende hata bulunduğu varsayılırsa özel bir yöntem şekli olan değişkenler-içinde-hata modeli teknikler kullanılarak model kurulmalıdır.

- Hatalar zaman içinde ve kendi aralarında birbirine bağımlı değildir. Buna otokorelasyon veya serisel korelasyon bulunmaması varsayımı adı verilir.

- Hata varyansı sabittir ve veriler arasında hiç değişmediği varsayılır. Bu eşvaryanslılık veya homoskedastisite varsayımı adı ile anılır. Eger bu varsayim uygun degilse ağırlıklı en küçük kareler yöntemi uygulanabilir.

- Hataların varyans-kovaryans matrisinin çapraz elamanları sabit hata varyansı olur ve matrisin diğer çapraz dışı elemanları 0 olur.

- Eğer çoklu regresyon analizi yapılıyor ve uc veya daha cok parametre icin kestirim isteniyorsa, bağımsız değişkenlerin birbirleri ile bağlantısının olmaması gereklidir. Buna çoklu doğrudaşlık (multicolliearity) olmaması varsayımı adı verilir.

- Hatalar bir normal dağılım gösterir. Eğer bu hataların normalliği varsayımı uygun değilse genelleştirilmiş doğrusal model uygulanabilir.

Doğrusal regresyon

Anakütle doğrusal regresyon modeli

Doğrusal regresyonda, anakütle model belirlenmesine göre [1] bağımlı değişken parametrelerin bir doğrusal birleşiği olur. Dikkat edilirse parametrelerden bahis edilmektedir, çünkü bağımsız değişkenlerin bir doğrusal bileşiği olması gerekli değildir. Örneğin, tek bir bağımsız değişkenli () ve iki parametreli ( ve ):

- dogru:

Burada bir hata terimidir ve alt-indeksleri bir belirlenmiş mümkün gözlemi ifade eder. Ayrıca , 'nci gözlemin regresyon doğrusuna olan uzaklığını ifade etmekte olup ortalaması 0 ve varyansı olan bir normal dağılış gösterir.

Çoklu doğrusal regresyonda iki veya daha çok sayıda bağımsız değişken veya bağımsız değişken fonksiyonu bulunur. Örneğin, önce verilmiş olan regresyon modeli yeni bir terim xi2 eklenerek degistirilirse; şu anakütle çoklu doğrusal regresyon modeli ortaya çıkar:

- parabol:

Denklemin sağ tarafındaki bağımsız değişken için bir ikinci derece (kuadratik) ifade bulunmasına rağmen bu model hala doğrusal regresyon modelidir; çünkü üç tane parametre, yani , ve ile çoklu değişkenli doğrusaldır.

Daha genel çoklu doğrusal regresyon modelinde p tane bağımsız değişken olduğu varsayılır ve anakütle modeli şöyle ifade edilir:

veya biraz daha kısa olarak

İki Değişkenli regresyon katsayı kestirimleri

Anakütleden bir rastgele örneklem elde edilirse, bu anakütle parametreleri için örneklem tahminleri bulunur ve şu örneklem doğrusal regresyon denklemi elde edilir:

Burada terimi örneklemden elde edilen artık olur; ve

olur.

Bu örneklem regresyon denkleminin kestirimini elde etmenin yöntemi adi en küçük kareler (Ordinary least squares) olarak adlandırılır.[1] Bu yönteme göre parametre kestirimleri artıkların kare toplamının minimum (en küçük) değerini bulmakla elde edilir. Artıklar minimum toplamı AKT şudur:

Bu fonksiyonun minimum değerini bulmak her parametre ile birinci kısımsal türevi alınarak sıfıra eşitlenir. Böylece her kısimsal türeve göre bir denklem elde edilir. Örneğin iki parametreli doğrusal regresyon için iki değişkenli iki denklem elde edilir. Bu simultane denklem sitemine normal denklemler adı verilir ve bu simultane denklemler sistemi birlikte çözülüp her anakütle parametresi için bir kestrim değeri bulunur.

İki parametreli basit doğrusal regresyon için iki anakütle parametre kestirimleri olan şu normal denklemlerin birlikte çözülmesi ile elde edilir:

Burada bütün toplamlar i=1 den i=n kadardır ve örneklem toplamları, toplam kareleri ve toplam karşı çarpımı ile elde edilirler.

Bu iki değiskenli iki doğrusal denklem için çeşitli çözüm yolları vardır. Burada Cramer'in kuralı kullanılıp şu ifade elde edilir:

burada

Böylece iki parametreli doğrusal regresyon icin en küçük kareler parametre tahminleri için formüller şöyledir:

- a

ve

Burada gözlem değerlerinin ortalaması ve ise gözlem değerlerinin ortalamasıdır.

Çok değişkenli regresyon katsayı kestirimleri

Çok değişkenli regresyon için regresyon katsayısı kestrimi de iki değişkenli regresyon hâli gibi en küçük kareler yöntemi ile yapılır.[1] Bu demektir ki kestirmde ortaya çıkacak artıkların karelerinin toplamı minimize edilecektir. Artıklar ri olur ve minimize edilecek objektif fonksiyon soyle ifade edilir:

Her bir artık, gözlemi yapılan bir değer ile kestirim modelini kullanarak elde edilen bir kestirim değeri arasındaki farktır:

En küçük kareler yöntemine göre S, toplam artıklar karesi, minimize edilecektir. Belirli koşullar gecerli ise, elde edilecek parametre kestrimleri (Gauss-Markov teoremine göre) en küçük varyans gösteren kestirim ve hatta maksimum değişirlilik özelliği gösteren dogrusal kestirim olabilirler.

Anakütle regresyon katsayılarının kestirim regresyon katsayıları için bir ^ (şapka) notasyonu kullanılanılır: yani . Genellikle çok değişkenli regresyon için normal denklemler şöyle ifade edilir

Matris notasyonu kullanılırsa, normal denklemler şöyle yazılabilir:

Eğer matrisi singuler değilse

- ,

Bu doğru uydurma tahminleridir.

Hatalar varyansı ve toplam kareler

Anakütle hatalarının normal dağılım gösterdiğine dair bir diğer varsayımı da kullanarak incelemeci önce hatalar varyansı ve toplam kareler değerlerini bulur ve bunları kullanarak tahmin edilen denklem ve parametreler üzerinde çıkarımsal istatistik sonuçlara varabilir.[1]

Anakütle hata teriminin sabit bir varyansı bulunduğu varsayımına göre, hatalar varyansı kestirimi şöyle bulunur:

Bu ifadeye regresyon için kare kök ortalama hata karesi adı verilir. Parametre kestirimleri için standart hata şöyle bulunur:

Örneklem veri serisinin değişebilirliği değişik toplam kareler suretiyle ifade edilebilirler.

- Tüm toplam kareler (örneklem varyansına orantılı olur):

- .

- Regresyon toplam kareler: Bazan açıklanan toplam kareler diye anılır.

- Toplam hatalar karesi: Artıklar toplam karesi olarak da isimlendirilir.

Bir regresyon modeli için parametreler, en küçük kareler yöntemi kullanılarak, tahmin edildikten sonra regresyon kontrol etme yöntemleri (yani çıkarımsal kontrol) uygulamak gerekir. Bunlar bulunan tahmin edilmiş genel doğrusal denklemin örnekleme uyum iyiliği sınaması ve kestirimci regresyon katsayılarının tektek istatistiksel anlamlılığını sınamak veya güvenlik aralığı sağlamak olarak özetlenir.

Kestirim denklemin genel uyum iyiliğinin çıkarımsal kontrolü

Tahmin edilen doğrusal regresyon denkleminin genel olarak örnekleme uygun olup olmadığı için uygulanan çıkarımsal istatistik işlemleri iki türde olabilir:[1]

- belirleme katsayısı yani R-kare değerinin bulunması;

- regresyon denklemine F-sınaması uygulaması.

Bu iki çıkarımsal kontrol aynı konunun çıkarımsal kontrolu için kullanılır: tahmin regresyon denkleminin tümünün uygun olup olmadığı. Bu nedenle iki yöntemden tek birini kullanmak yeterlidir. Buna rağmen birçok pratik analizde her iki çıkarımsal analiz de kullanılmaktadır; çünkü ikisinde hesaplanması için nerede ise aynı yöntem kullanılır ve eger istatistik veya ekonometrik kompüter paketi kullanılırsa her iki yöntem için gerekli sonuçlar birlikte verilir.

Belirleme katsayısı yani R-kare (R2) değeri

Belirleme katsayısı yani (R2) ) R-kare) için en genel tanımlama förmülü sudur:[1]

- .

yani (1-toplam hatalar karesi) ile (tüm toplam kareler) oranı; veya (1-Artıklar toplam karesi) ile (tüm toplam kareler) oranı.

Çıkarımsal analizde R-kare değeri bulunur ve bulunan değer doğru hesaplanmışsa 0 ile 1 arasında olmalıdır. Yapılan bu analiz ceşitli hallerde açıklanabilir:

- Eğer sadece iki değiskenli (Y ve X0) regresyon analizi yapılıyorsa, geometrik olarak X-Y düzeyinde doğrusal regresyon tahmini bu düzeyde olan noktalara en-küçük-kareler prensibine göre en iyi uyan bir doğru uydurmaktır. Eğer bütün noktalar bu tahmin edilen doğru üzerinde ise tahmin edilen doğru uyumu bu veri noktaları için hiç hatasızdır ve veri noktaları doğrudan hiç ayrılık göstermez. Hat varyasyonu bu halde sıfır olur. Bu veri noktaları tahmin edilen doğrudan uzaklaştıkça hatalar varyasyonu çoğalmaktadır.

- Üç değişkenli (Y ve X1 ve X2 değişkenli) çoklu regresyonda ise tahmin edilen bir üç boyutlu düzeydir. Eger bu düzey veri noktalarına tam olarak uyarsa bütün veri noktaları tahmin edilen düzey üstüne düşerler. Veri noktaları tahmin edilen düzey etrafında dağılmaya başlarlarsa, hatalar varyasyonu artmaya başlar.

- Üç değişkenden daha çoklu değişkenli regresyon analizi ise grafik olarak verilemez; çok boyutlu uzayı gösterir ve tahmin edilen regresyon katsayıları ise bu cok boyutlu uzayda bir hiper-düzey ortaya çıkartır ve bu hiper-düzeyden ayrılmalar hata varyasyonudur.

Genel olarak:

- Eğer R2 değeri sıfıra yakınsa, uyum iyiliği uygun olmadığı kabul edilir. Bu sonuç ortaya çıkarsa toplanan verilere kullanılan modelin uygun olmadığı sonucu çıkarılır ve bu uygunsuzluk modelinin değiştirilmesini gerektirir. Bu demektir ki model ile açıklanan varyasyon tüm varyansyonu %0ini açıklamakta ve geometrik olarak orneklem verileri regresyon ile elde edilen hiperduzeyin etrafına çok dağılmış olarak bulunmaktadırlar. Bu çıkarıma varılırsa bu basamağa kadar yapılmış olan analizin bir kenara bırakılması ve diğer bir modelin bulunup kullanılması gerekir.

- Eğer R2 değeri bire yakınsa, uyum iyiliği uygun olduğu sonucu çıkarılır. Geometrik olarak çok değişken boyutlu uzayda, örneklem veri noktalarının hepsi uzayda dağılma göstermeyip hemen hepsi regresyon ile elde edilen hiperduzey üzerinde bulunmaktadır. Bu halde çıkarımsal kontrol analizinin diğer basamağına geçilir.

F-testi

Regresyon denklem uyum iyiliği için F-testi için sıfır hipotez (H0) anakutle model katsayilarinin hepsinin değerinin 0 (sifir)a eşit olduğudur.[1] Yani sıfır hipotez gerçekse hesap ile elde edilen katsayi kestirimlerinin hepsi anakütle için 0dir yani hiçbir etki ve bağlantı anlamı vermez. Bu basamağa kadar yapılmış olan analizin bir kenara bırakılması ve diğer bir modelin bulunup kullanılması gerekir. Eğer sıfır hipotez reddedilirse regresyon kestirimleri genellikle uygundur ve cikarimsal kontrol analizine devam edilir.

Kestirimi yapılan her tek regresyon parametresinin değerinin çıkarımsal kontrolu

Yani bu tahmin edilmiş standart hataları kullanarak her tek anakütle regresyon parametresi hakkında kestirim güvenlik aralıkları kurabilir ve hipotez sınamaları yapılabilir.[1]

İnterpolasyon ve ekstrapolasyon

Regresyon modelleri kullanarak kestirim yapılmak istenirse, bağımsız değişken olan değişken veri değerleri verilirse bağımlı değişken için kestrim değerleri () tahmin etmek için kullanabilirler.

Eğer bu kestirim, modeli kurmak için kullanılan değişken değerleri için yapılıyorsa, bu işlem interpolasyon olarak adlandırılır. Eğer kestirim modeli kurmak için kullanılan bağımsız değişken değerlerinin dışındaki değerler ile yapılırsa, ekstrapolasyon olarak adlandırılır ve ekstrapolasyon çok daha yanlı olabilir.

Diğer yaklaşımlar

Ağırlıklı en küçük kareler yöntemi

En küçük kareler yöntemi kullanılırken yapılan temel varsayımlarindan biri hata terimi varyanslarının birbirine esit olduğudur. Eğer gözlem hataları birbirine eşit olmayan hata terimi varyanslari gösteriyorlarsa, en küçük kareler yönteminin bu önemli varsayımı ihlal edilmiş olur ve en küçük kareler yöntemi ile elde edilen regresyon kestirimleri anlamlı olmayabilir. Bu sorunu çözümlemek için her gözleme ayrı ağırlık vererek en küçük kareler yöntemi uygulamak imkânı vardır ve bu genelleştirmeye ağırlıklı en küçük kareler adı verilir. Ağırlıklı En Küçük Kareler Yöntemi,değişkenlere ağırlık vererek veya değişkenlerin önem derecesini değiştirerek uygulanan en küçük kareler yöntemidir.

Değişkenlerde-hatalar modeli

En küçük kareler yöntemi kullanılırken yapılan temel varsayımlarından biri de gözlem hatalarının yalnızca bağımlı değişkenlerde yapıldığı ve bağımsız değişkende gözlem hatası bulunmadığıdır. Eğer bağımlı değişkende hata bulunduğu ve bunun elde edilen regresyon kestirim değerlerine çok etki yaptığı bilinirse, degiskenlerde-hatalar-modeli veya diğer ismi ile total en kucuk kareler modeli ve bu modelle ilişkili kestirim yöntemleri kullanılabilir.

Genelleştirilmiş doğrusal model

Eğer anakütle regresyon modeli içindeki hatalar için olasılık dağılım fonksiyonu bir normal dağılım göstermiyorsa genelleştirilmiş doğrusal model kullanılabilir. Bu halde hatalarin olasılık dağılım fonksiyonu ussel dağılım, gamma dağılımı, ters Gauss tipi dağılım, Poisson dağılımı, binom dağılım, multinom dağılım vb. olabilir.

Doğrusal olmayan regresyon

Eğer değişkenler hakkında kurulan teori dolayasıyla anakutle modeli parametrelri ile doğrusal değilse, kestirim yapılırken toplam kareleri tekrarlama usulu kullanarak minimize edilmesi gerekir. Bu kullanılan tekrarlama yöntemi birçok karışık sorunlar ortaya çıkarır. Bunların özet olarak incelenmesi için doğrusal olmayan regresyon#Dogrusal olmayan ve dogrusal en kucuk kareler arasindaki farklar maddesine bakiniz.[1]

İçsel kaynaklar

- Parçalar için regresyon

- Güvenlik aralığı

- Güvenlik yöresi

- Ekstrapolasyon

- Krigleme

- Tahmin etme

- Tahmin aralığı

- İstatistik

- Trend kestirimi

- Güçlü regresyon

- Çokdeğişirli normal dağılım

Kaynakça

- 1 2 3 4 5 6 7 8 9 10 11 Gujarati, Damodar (çev. Ümit Şenesen, Gülay Günlük Şenesen) (2008) Temel Ekonometri, Literatür Yayınları ISBN 975-7860-99-9.

- ↑ A.M. Legendre (1805), Nouvelles méthodeş pour la détermination des orbites des comètes. “Sur la Méthode des moindres quarrés” bir ek bölümde bulunur.

- ↑ C.F. Gauss (1809), Theoria Motus Corporum Coeleştium in Sectionibüs Conicis Şölem Ambientum.

- ↑ C.F. Gauss (1821/1823). Theoria çombinationis observationum erroribüs minimiş obnoxiae.

- ↑ Francis Galton (1877), "Typical laws of heredity", Nature 15, 492-495, 512-514, 532-533. (Galton burada bezelyelerle yaptığı kalıtım deneyi sonucunda reversion terimi kullanır.)

- ↑ Francis Galton (1885) Presidential address, Section H, Anthropology.(Burada insanlarin boylari uzerinde yaptigi arastirma sonucu için "regression" terimi kullanir.)

- ↑ G. Udny Yule (1897) "On the Theory of Correlation", J. Royal Statist. Soç., 1897, p. 812-54.

- ↑ Karl Pearson, G.U.Yüle, Norman Blanchard, and Alice Lee (1903). "The Law of Ancestral Heredity", Biometrika

- ↑ R.A. Fisher (1922), "The goodness of fit of regression formulae, and the distribution of regression çoefficients", J. Royal Statist. Soç., 85, 597-612

- ↑ R.A. Fisher (1925),Statistical Methods för Research Workers

Bibliyografya

- Gujarati, Damodar (çev. Ümit Şenesen, Gülay Günlük Şenesen) (2008) Temel Ekonometri, Literatür Yayınları ISBN 975-7860-99-9.

- Audi, R., Ed. (1996). "Curve fitting problem," The Cambridge Dictionary of Philosophy. Cambridge, Cambridge University Press. pp. 172–173. (İngilizce)

- William H. Kruskal and Judith M. Tanur, ed. (1978), "Linear Hypotheses," International Encyclopedia of Statistics. Free Press, cilt 1 (İngilizce)

- Evan J. Williams, "I. Regression," say. 523-41.

- Julian C. Stanley, "II. Analysis of Variance," pp. 541-554.

- Lindley, D.V. (1987). "Regression and correlation analysis," New Palgrave: A Dictionary of Economics, Cilt. 4, say. 120-23. (İngilizce)

- Birkes, David and Yadolah Dodge, Alternative Methods of Regression. ISBN 0-471-56881-3 (İngilizce)

- Chatfield, C. (1993) "Calculating Interval Forecasts," Journal of Business and Economic Statistics, 11. pp. 121–135. (İngilizce)

- Dinçer, F. "Regresyon Kelimesinin Tarihi",

- Draper, N.R. ve Smith, H. (1998).Applied Regression Analysis Wiley Series in Probability and Statistics (İngilizce)

- Fox, J. (1997). Applied Regression Analysis, Linear Models and Related Methods. Sage (İngilizce)

- Hardle, W., Applied Nonparametric Regression (1990), ISBN 0-521-42950-1 (İngilizce)

- Meade, N. ve T. Islam (1995) "Prediction Intervals for Growth Curve Forecasts," Journal of Forecasting, 14, say. 413-430. (İngilizce)

- Munro, Barbara Hazard (2005) "Statistical Methods for Health Care Research 5th ed." Lippincott Williams & Wilkins, (İngilizce)

- Sykes, A.O. "An Introduction to Regression Analysis" (Innaugural Coase Lecture)

- Kotsiantis,S., Kanellopoulos,D. ve Pintelas,P. (2006) "Local Additive Regression of Decision Stumps", Lecture Notes in Artificial Intelligence, Springer-Verlag, Vol. 3955, SETN 2006, say.. 148 – 157 (İngilizce)

- Kotsiantis,S. ve Pintelas, P. (2005) "Selective Averaging of Regression Models", Annals of Mathematics, Computing & TeleInformatics, Cilt 1, No 3, say. 66-75 (İngilizce)

Dış bağlantılar

- Regresyon analizi

- Curvefit: A complete guide to nonlinear regression - Online ders kitabı

- RM4E ile regresyonun kolaylaştırılması

- Doğrusal model üzerine yorumlar - Bill Venbables tarafından bazı doğrusal regresyon modelleri üzerinde birkaç yorum.

- Mazoo's Learning Blog - Doğrusal regresyon için örnek. Doğrusal regresyon denkleminin, varyansların, standart hataların, korelasyon katsayısının, belirleme katsayısının ve güvenlik aralıklarının nasıl bulunduğunu göstermektedir.

- Zayif korelasyon bağlantılı verilerin regresyonu - Y -aralığı X-aralığından çok daha küçük olursa nasıl regresyon hataları ortaya çıkabilir.

- xuru.org Online regresyon avadanlığı

- Matlab SUrrogate MOdeling Toolbox - SUMO Toolbox - Aktif öğrenme + Model seçimi + Vekil modeli regresyonu için Matlab yazılımı

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| ||||||||||||||||||||||||||||||||||||||||||